云計算環境下,數據中心網絡主要面臨2 個瓶頸。一是數據中心的核心交換設備,它作為數據中心所有業務系統之間,以及業務系統和用戶之間的交換樞紐,將會是所有流量匯集的地方,所以網絡核心的性能壓力最大,是可能的瓶頸所在。另一個就是安全設備,安全設備的性能往往落后于網絡設備一個級數,而其在企業數據中心的部署又是必不可少的防護措施,所以如何突破安全的性能瓶頸至關重要。

網絡技術和數據中心的發展,同樣推動了數據中心級交換機的出現,目前數據中心級的核心交換機(例如H3C的S12500和Cisco的Nexus 7000)已經成為數據中心核心網絡的寵兒。基于CLOS 的多級交換架構,使其具備了10T以上的交換容量,能夠支持高密度的萬兆端口,具有更好的擴展性,能夠很好地緩解數據中心核心網絡的交換壓力,解決核心網絡性能瓶頸。另一方面,雖然部分高端安全設備已經搭建在10G平臺之上,但依然不能滿足對其在性能上的高要求,所以目前最好的解決方法就是將萬兆的安全設備與網絡設備結合部署,通過在網絡設備中部署支持安全模塊實現性能累加。該方式在當前的數據中心建設中已經逐漸成為了主流方案,不但可以解決安全設備帶來的性能瓶頸,而且可以解決安全系統部署在可靠性和空間上遇到的種種難題。

因此,在數據中心網絡部署時,建議核心交換設備采用基于100G平臺的數據中心設備,以保障網絡的性能和可靠性;在匯聚層通過部署萬兆交換機及嵌入式安全業務模塊,來消除安全系統的性能瓶頸,并提供更好的擴展性。

4.2 三網分離設計

云計算數據中心涉及的網絡分為3個:業務網絡、管理網絡和數據遷移網絡。業務網絡用來承擔虛擬機之間和對外的業務數據流量;管理網絡用來承載云管理平臺對物理機、虛擬機的管理維護;數據遷移網絡用于虛機遷移時在不同物理機之間拷貝虛機內存數據。

為了避免3個網絡之間互聯占用資源,在云計算數據中心網絡設計時應考慮對這3個網絡進行分離,物理機配置網卡時分為3組獨立的網口,分別對應到3個上聯網絡,上聯網絡設備也宜采用不同的交換機,實現三網分離。

4.3 構建大二層網絡

當虛擬機在物理服務器之間進行遷移時,為了避免虛擬機遷移后路由的震蕩和修改網絡規劃,遷移只能在二層域進行,因此數據中心需要具備一個性能更高、二層域更大的網絡環境為遷移提供保障。

4.3.1 傳統以太網的瓶頸

在傳統以太網中使用生成樹協議STP來確保無環,但STP會導致網絡中部分路徑被阻塞,浪費端口和鏈路帶寬,且鏈路故障時收斂時間長(通常在秒級),在節點規模達到一定數量級時其設計和維護都會變得異常困難,因此云計算中需要新的技術在避免環路的基礎上提升多路徑帶寬利用率。

網絡核心層流量壓力增大。云計算環境下為了構建大二層網絡,通常采用扁平化的網絡設計,大量服務器的流量上行到網絡核心節點處理,因此會給核心層網絡設備帶來很大壓力。傳統的固定處理能力的網絡設備不能滿足持續擴展的云計算網絡的需求,需要采用可橫向擴展的網絡設備虛擬化技術。

4.3.2 網絡設備多虛一

交換機在整體架構上分為控制平面和數據平面。控制平面主體是CPU,處理協議報文,數據平面主體是ASIC芯片,處理數據報文轉發。網絡設備虛擬化分為控制平面虛擬化和數據平面虛擬化。

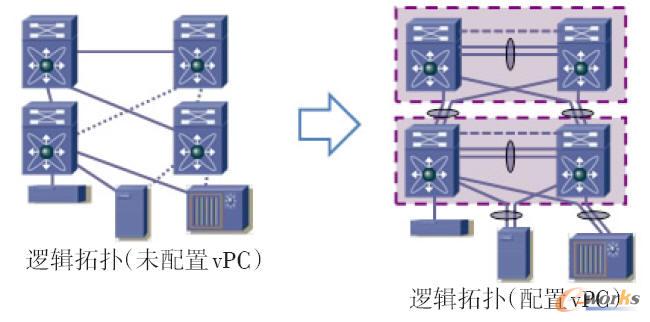

控制平面虛擬化是將所有設備的控制平面合而為一,只有一個主體去處理整個虛擬交換機的協議處理、表項同步等工作,數據平面上所有的機框和盒子都可以對流量進行本地轉發和處理。Cisco的VSS/vPC和H3C的IRF都是比較成熟的控制平面虛擬化技術的代表。Cisco vPC(Virtual Port-Channel)技術可以實現在單個設備上使用port-channel連接2個上行交換機,完全使用所有上行鏈路的帶寬,并消除STP blocked ports,在link/device失效下提供快速收斂(見圖2)。

圖2 vPC示意圖

控制平面虛擬化從一定意義上來說是真正的虛擬交換機,能夠同時解決統一管理與接口擴展的需求。但是仍然存在擴展性的瓶頸,控制平面多虛一時,控制平面處理整個虛擬交換機運行的物理控制節點主控板都只能有一塊為主,其他都是備份角色(類似于服務器多虛一中的HA結構)。總而言之,虛擬交換機支持的物理節點規模永遠會受限于此控制節點的處理能力。

為了解決控制平面虛擬化的瓶頸,業界提出了數據平面的虛擬化。數據平面多虛一技術的特征就是在二層Ethernet 報文外面再封裝一層標識用于尋址轉發,這樣基于外層標識就可以做些多路徑負載均衡和環路避免等處理工作了。典型的技術有IETF提出的TRILL(TRansparent Interconnect of Lots of Links)和IEEE 提出的SPB(Shortest Path Bridging)2 套標準技術,另外一些廠商在此之上也提出了一些私有技術,如Cisco的FabricPath技術、Juniper的QFabric技術。

以TRILL 為例,TRILL 在控制平面上引入了L2ISIS作為尋址協議,運行在所有的TRILL RB(RoutingBridge)之間,部署于一個可自定義的獨立協議VLAN內,完成建立鄰接、繪制拓撲和傳遞Tag等工作。數據平面在內外層Ethernet報頭之間引入了TRILL報頭,使用Nickname作為轉發標識,用于報文在TRILL網絡中的尋址轉發。每個RB都具有唯一的Nickname,同時維護其他RB 的TRILL 公共區域MAC 地址、Nickname和私有區域內部MAC地址的對應關系表。

4.3.3 網絡設備一虛多

在同一個云計算網絡需要劃分不同資源池或者云計算網絡和非云計算網絡共用網絡設備時,需要用到網絡設備一虛多技術。典型的網絡設備一虛多技術是Cisco提出的VDC(Virtual Device Content)技術。VDC技術可以將一臺物理交換機邏輯上模擬成多臺(最多4臺)虛擬交換機,可以實現每個模擬出的VDC都擁有它自身的軟件進程、專用硬件資源(接口)和獨立的管理環境,可以實現獨立的安全管理界限劃分和故障隔離域。VDC技術有助于將分立網絡整合為一個通用基礎設施,保留物理上獨立的網絡管理界限劃分和故障隔離特性,并具有單一基礎設施所擁有的多種運營成本優勢。

4.3.4 廣域二層互聯

當2個異地云計算數據中心需要納入統一資源池,實現跨局址的虛擬機遷移時,需要做到跨越三層網絡的二層互聯,Cisco 提出的OTV(Overlay TransportVirtualization)技術可以解決這一問題。OTV技術可以為跨任意傳輸網絡的二層連接擴展,提供運營優化型解決方案。因此,OTV對于分布式數據中心的高效部署發揮著關鍵作用,有助于實現應用可靠性和靈活的工作負載遷移。OTV是一項“MAC in IP”技術。通過使用MAC地址路由規則,OTV可提供一種疊加網絡,能夠在分散的二層域之間實現二層連接,同時保持這些域的獨立性以及IP互聯的容錯性、永續性和負載均衡優勢。

4.3.5 虛擬交換

虛擬交換就是利用虛擬平臺,通過軟件的方式形成交換機部件。跟傳統的物理交換機相比,虛擬交換機同樣具備眾多優點。一是配置更加靈活,一臺普通的服務器可以配置出數十臺甚至上百臺虛擬交換機,且端口數目可以靈活選擇。例如,VMware的ESX一臺服務器可以仿真出248臺虛擬交換機,且每臺交換機預設虛擬端口可達56個。二是成本更加低廉,通過虛擬交換往往可以獲得昂貴的普通交換機才能達到的性能,例如微軟的Hyper-V平臺,虛擬機與虛擬交換機之間的聯機速度可達10 Gbit/s。

思科發布了針對VMWare的Nexus 1000V虛擬交換機,Nexus 1000V具備更多的網絡功能,例如Netflow流量控制、QoS、ERSPAN、VLAN 以及Access ControlList(ACL)的聯機控制等。該款虛擬交換機支持虛擬機的動態遷移,在虛擬機遷移的過程之中,原本對應到該臺虛擬機從事管理的交換機設置,也會跟著一起遷移到其他ESX服務器的Nexus 1000V交換機上繼續使用。在管理上,Nexus 1000V的角色就如同安裝在交換機機箱內的線路卡,其配置管理操作在上聯的Nexus系列物理交換機上完成,簡化了網絡配置管理操作。

5 結束語

云計算作為IT業界的一項技術和管理模式的創新,對數據中心的設計也提出了新的要求。在云計算數據中心設計過程中,需要關注虛擬化后帶來的性能、擴展性、可管理性等方面的要求,選擇合適的設備和技術,從而實現云計算數據中心合理規劃和設計。

核心關注:拓步ERP系統平臺是覆蓋了眾多的業務領域、行業應用,蘊涵了豐富的ERP管理思想,集成了ERP軟件業務管理理念,功能涉及供應鏈、成本、制造、CRM、HR等眾多業務領域的管理,全面涵蓋了企業關注ERP管理系統的核心領域,是眾多中小企業信息化建設首選的ERP管理軟件信賴品牌。

轉載請注明出處:拓步ERP資訊網http://m.hanmeixuan.com/

本文標題:IaaS云計算數據中心設計探討(下)